De nouvelles technologies détectent les émotions pour réaliser des tests ou améliorer les parcours d’achat en magasin.

« C’est l’année de la computer vision au Vivatech », annonce Guillaume Rio, responsable tendances technologiques à L’Echangeur BNP Paribas Personal Finance qui organisait des visites guidées de ce vaste salon dédié à l’innovation et aux startups. Lors de la saison précédente, nombre de développements faisant appel à la voix y étaient exposés. Cette année, la place est à l’image et à la « computer vision ». Cette utilisation de l’intelligence artificielle permet à l’ordinateur d’analyser, d’interpréter et in fine de comprendre des images. Les réalisations présentées prétendent reconnaître les formes, les objets, les identités, mais aussi repèrent l’expression du visage et l’humeur de la personne.

Le magasin complètement automatisé imaginé par le chinois Cloudpick était parmi les plus spectaculaires. La solution utilisée déjà dévoilée lors du dernier salon NRF est similaire à Amazon Go. Ce point de vente fonctionne sans personnel (sauf pour les réapprovisionnements), sans caisse, ni étiquettes ou portiques antivol. Il n’utilise aucune technologie à ondes de type Rfid et tout fonctionne grâce à des batteries de caméras. L’achat est piloté par une application que le consommateur doit activer sur son smartphone à l’entrée du magasin. Il peut ensuite ranger son téléphone et continuer tranquillement ses courses et est en permanence identifié et suivi grâce à ses données biométriques et à la « computer vision ». Tous les articles qu’il choisit sont aussi repérés par les caméras et additionnés à son caddie virtuel. Un article reposé sera automatiquement soustrait du caddie. A la sortie, pas de check-out, dès que le consommateur aura franchi les portiques le montant de son caddie est automatiquement payé avec Alipay ou Wechat, et le ticket de caisse dématérialisée arrive dans l’application.

Cloudpick travaille déjà avec l’enseigne 7-Eleven et Auchan envisagerait l’expérimentation du magasin automatisé sur des formats entre 800 et 1500 m², hors de France. D’autres retailers s’y intéressent comme JD.com.

Cloudpick travaille déjà avec l’enseigne 7-Eleven et Auchan envisagerait l’expérimentation du magasin automatisé sur des formats entre 800 et 1500 m², hors de France. D’autres retailers s’y intéressent comme JD.com.

Le visage du consommateur est désormais l’objet de toutes les attentions, et plus particulièrement son expression. Le logiciel du britannique Real Eyes détecte ainsi l’émotion sur un visage quand un consommateur est surpris ou inquiet. Installée dans le rayon, une caméra reliée à l’ordinateur pourra procéder à des tests de packaging ou bien à faire de la publicité sur les lieux de vente. Petite astuce, cette solution reconnaît et comptabilise les émotions exprimées mais n’enregistre pas les images, ce qui devrait dispenser d’une déclaration à la Cnil.

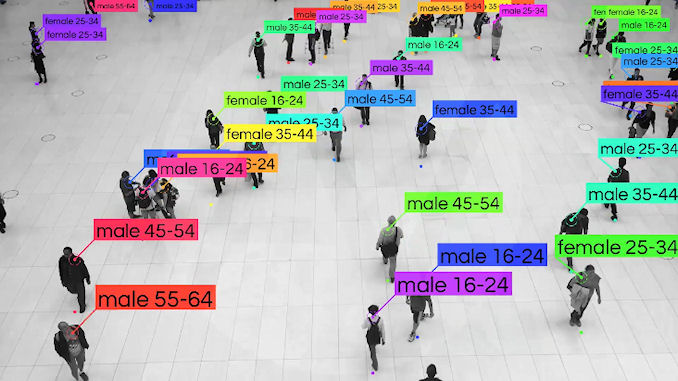

Plusieurs entreprises chinoises ont présenté des solutions similaires de « computer vision ». Comme Aura Vision qui sait reconnaître le genre et l’âge du client, associés au temps qu’il a passé devant l’article exposé.

Le lillois Affect-Tag a conçu un bracelet qui, placé sur le poignet, capte les signaux physiologiques du consommateur : la température, le mouvement, le rythme cardiaque, l’activité électro-thermale. « Nous pouvons en déduire des indicateurs comme la puissance de l’émotion ressentie, son intensité, mais aussi la charge cognitive autrement dit la concentration de l’individu », explique Olivier Janin, Pdg de la startup. Le bracelet est le fruit de cinq années de recherche menée en partenariat avec l’Université de Lille. Sa finalité est de pouvoir tester les émotions du client en magasin, grâce à des tags posés à différents endroits pour rapprocher une émotion d’un lieu. Une enseigne de grande distribution et un détaillant spécialisé en parfumerie s’y intéresseraient pour tester leurs points de vente.

La technique du bracelet a un inconvénient : le bracelet. Il ne peut être attaché au poignet de tous les consommateurs qui passent. Mais Wallmart a trouvé la parade, le distributeur a déposé un brevet pour utiliser la même technologie que celle d’Affect-Tag mais cette fois-ci intégrée dans la poignée du chariot.

Retour à la « computer vision » avec Watiz, une startup française qui exploite les images des articles de mode. « Notre application permet de retrouver un vêtement à partir d’une photo. Nous avons voulu créer le « shazam de la mode » », explique Julien Capra, co-fondateur de l’entreprise incubée à l’Institut Mines-Télécom Business à Arcueil. Elle se spécialise aujourd’hui sur la mode féminine. « Vous voyez quelqu’un qui porte un vêtement qui vous plait, vous prenez la photo avec le smartphone, l’application recherche le vêtement dans sa base et vous redirige vers le site de la marque. Nous avons fait des tests, les femmes se projettent très facilement dans l’utilisation de l’appli. Elles en comprennent le fonctionnement tout de suite et ne demandent qu’à l’utiliser ».

Encore au stade béta aujourd’hui, l’application devrait être lancée sur le marché en automne, avec une cinquantaine de partenaires marques et distributeurs, totalisant près d’un million d’articles.

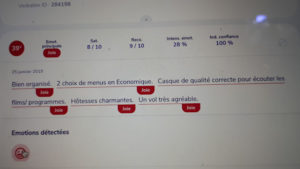

Les startups françaises se font une spécialité dans l’analyse de l’émotion, et pas seulement dans l’image. La solution de Q.Emotion détecte l’émotion dans le texte écrit. Elle permet de qualifier les sentiments du client vis-à-vis de la marque lorsqu’il répond à une enquête sur le site Web ou bien s’exprime sur les réseaux sociaux. « Notre solution procède par l’analyse sémantique, ensuite par la classification thématique, pour enfin parvenir à repérer l’émotion. Quelques 55 millions de mots et d’expressions sont qualifiées », explique Matthieu Bruneteau de Gorsse, cofondateur. Son application est déjà utilisée par le voyagiste TUI, par l’opérateur de restauration collective Sodexo, par des banques comme le Crédit Agricole ou la Caisse d’Epargne.

Les startups françaises se font une spécialité dans l’analyse de l’émotion, et pas seulement dans l’image. La solution de Q.Emotion détecte l’émotion dans le texte écrit. Elle permet de qualifier les sentiments du client vis-à-vis de la marque lorsqu’il répond à une enquête sur le site Web ou bien s’exprime sur les réseaux sociaux. « Notre solution procède par l’analyse sémantique, ensuite par la classification thématique, pour enfin parvenir à repérer l’émotion. Quelques 55 millions de mots et d’expressions sont qualifiées », explique Matthieu Bruneteau de Gorsse, cofondateur. Son application est déjà utilisée par le voyagiste TUI, par l’opérateur de restauration collective Sodexo, par des banques comme le Crédit Agricole ou la Caisse d’Epargne.

Laisser un commentaire